| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- MCU 딥러닝

- 코딩테스트

- 포스코 ai 교육

- 딥러닝

- 컴퓨팅사고

- 포스코 교육

- BFS

- 임베디드 딥러닝

- bfs문제

- dfs문제

- 삼성역테

- 자료구조

- 그리디

- 포스코 AI교육

- DP문제

- 다이나믹프로그래밍

- TensorFlow Lite

- 코테 문제

- tflite

- 삼성코딩테스트

- 삼성역량테스트

- sort

- 초소형머신러닝

- 코테

- dfs

- 삼성코테

- 알고리즘

- tinyml

- 영상처리

- DP

- Today

- Total

코딩뚠뚠

[AWS] 카톡분석 프로젝트-3 / S3 trigger로 Lambda 호출 본문

이전장 에서는 S3 저장소를 만들고 API Gateway를 통해 S3에 파일을 업로드해봤다.

[AWS-lambda] Lambda 구축하기-2

이전장 에서는 Lambda 함수를 만들고 API Gateway 트리거를 추가해줬다. Lambda 로 변경한 이유 우선 내가 구현해보려는 서비스는 많은 리소스" data-og-host="dbstndi6316.tistory.com" data-og-source-url="http..

dbstndi6316.tistory.com

이번장에서는

S3를 트리거로Lambda호출하기

를 해보려 한다.

아래 그림에서 오른쪽 Trigger from S3 부분에 해당된다.

S3를 트리거로Lambda 호출하기

1. S3 bucket 생성

- 저번장에서 생성해준 bucket 을 그대로 사용하려한다.

2. Lambda 함수 생성

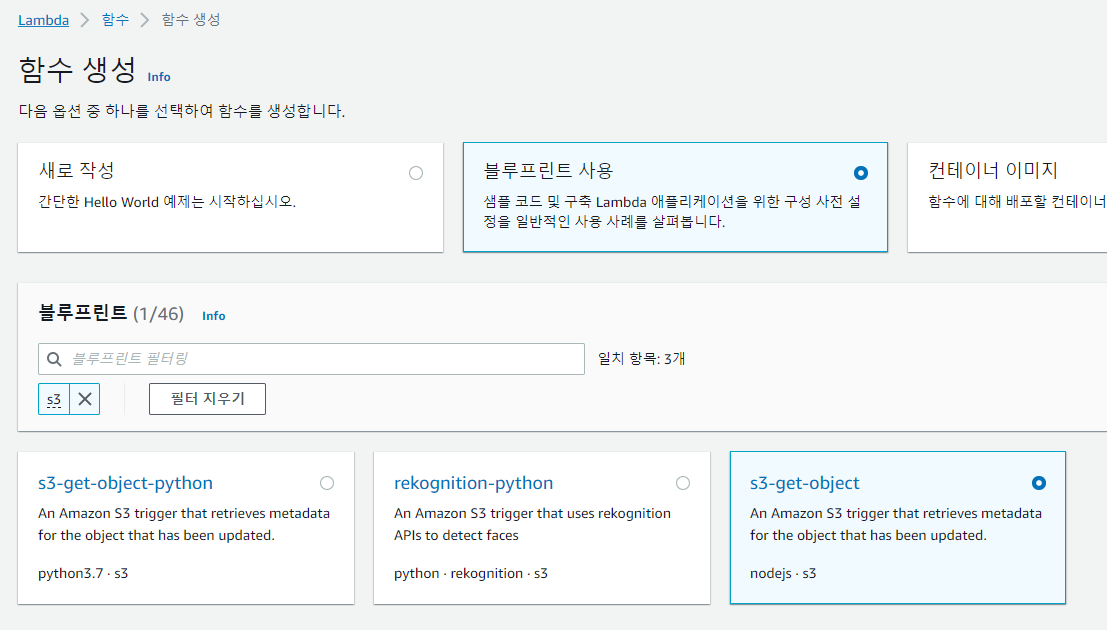

2.1 생성 - 블루프린트 사용 - s3-get-object

- 블루프린트를 사용해서 기본적인 코드가 이미 있는 함수를 만들어보자

- 어떤 코드가 이미 있는? -> s3-get-object 에 대한 내용이 있는 (python 을 사용하려면 s3-get-object-python을 선택)

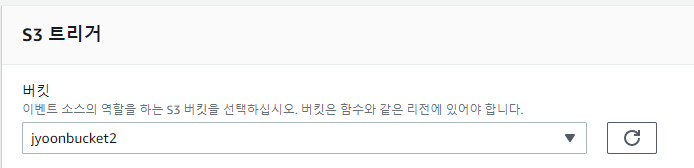

2.2 S3 trigger 설정후 함수 생성

- 함수 이름을 입력해주고 S3 트리거 부분에서 버킷을 선택해준다.

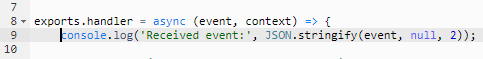

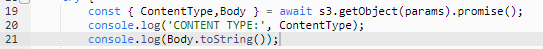

2.3 코드 수정

- 테스트 위해 주석 제거

- Body log를 남기기위해 추가

3. Upload 및 Log 확인 테스트

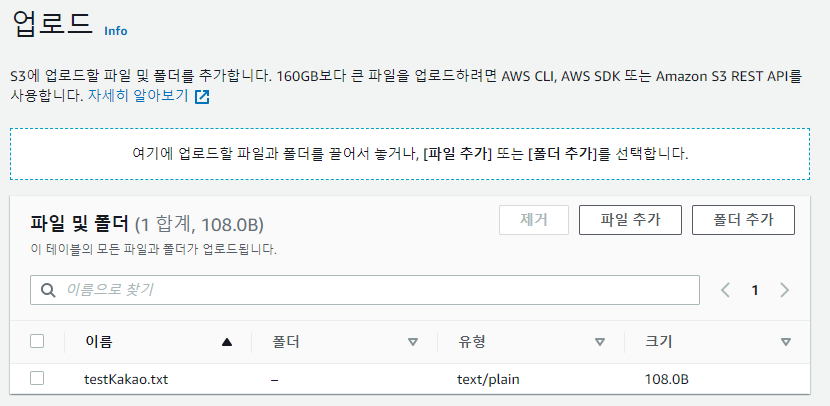

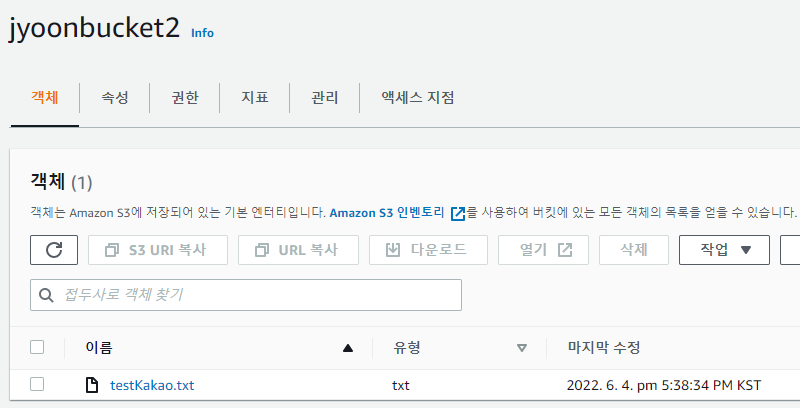

3.1 bucket에 파일을 업로드한다.

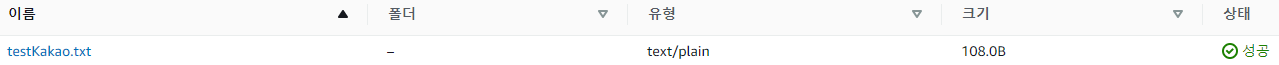

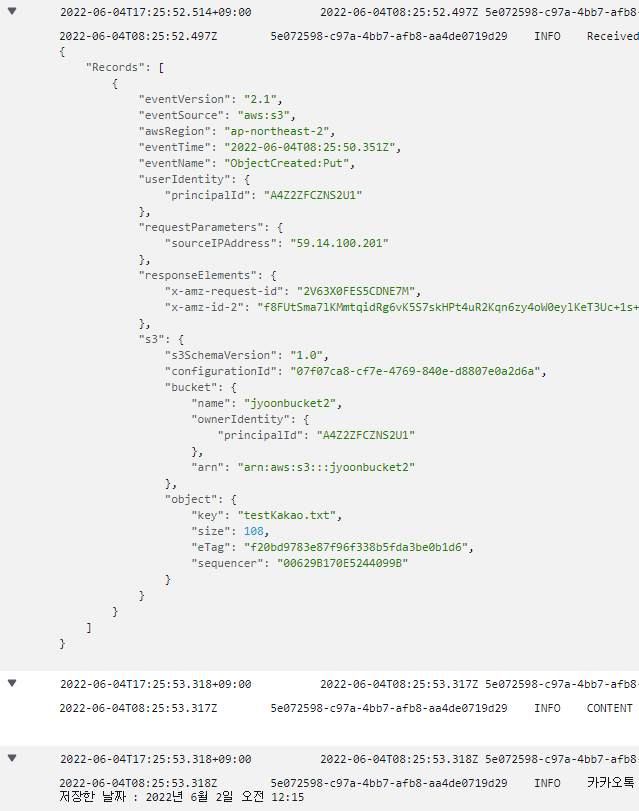

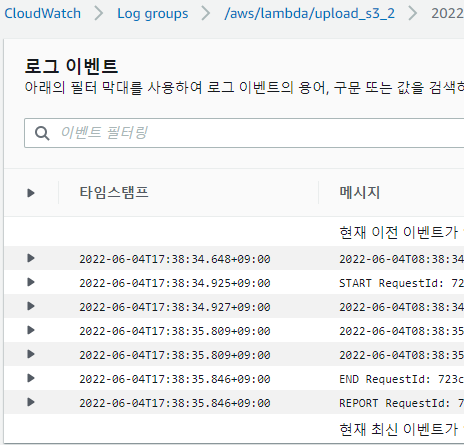

3.2 Cloudwatch 에서 로그를 확인한다

- cloudwatch 에 접근한다.

- Log 에서 txt의 upload 정보와 txt내용 등 여러 정보들을 확인할 수 있다.

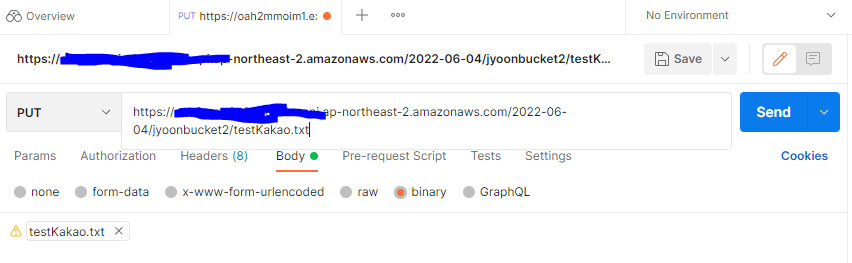

3.3 저번장에서 API Gateway -> S3 를 구축해봤다. 이번장에서는 S3 -> Lambda 이기 때문에 이 내용이 통합적으로 구동하는지 실험해보자

- 전체적인 과정

- Postman 을 통해 testKakao.txt 파일을 올려보자

- bucket 확인 : 업로드 성공

- Lambda 함수도 구동되었는지 Log 확인 : Lambda 함수 구동 성공

다음장에서는 File upload의 일련의 과정을 React 를 이용한 프런트엔드로 나타내보려한다

끝

다음장링크 :

[AWS] Lambda 구축하기-4 / React 연동 파일 업로드

이전장까지 S3 저장소를 만들고 API Gateway를 통해 S3에 파일을 업로드해봤다. [AWS] Lambda 구축하기-3 / S3 trigger로 Lambda 호출 이전장 에서는 S3 저장소를 만들고 API Gateway를 통해 S3에 파일을 업로드해..

dbstndi6316.tistory.com

References : https://www.youtube.com/watch?v=eAmjyy5yR3E

'공부 > AWS' 카테고리의 다른 글

| [AWS] 카톡분석 프로젝트-5 / S3 이용한 정적웹호스팅 (0) | 2022.06.05 |

|---|---|

| [AWS] 카톡분석 프로젝트-4 / React 연동 파일 업로드 (1) | 2022.06.05 |

| [AWS] 카톡분석 프로젝트-2 / API Gateway 통해 S3에 파일업로드 (1) | 2022.06.04 |

| [AWS] 카톡분석 프로젝트-1 / Lambda 시작하기 (3) | 2022.05.31 |

| [AWS] AWS EC2로 Django 배포하기 (1) | 2022.05.25 |